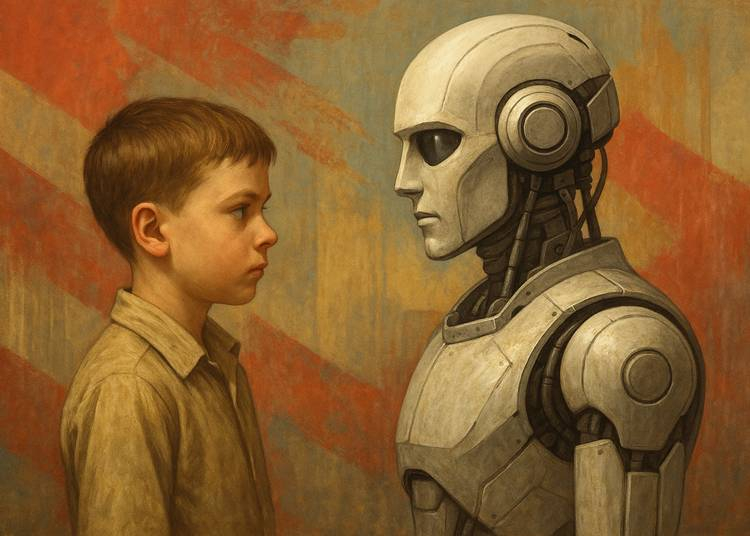

Az FTC 2025. szeptember 11‑én aláírt “Section 6(b)” rendeletek keretében leveleket küldött több vezető cégnek, köztük az OpenAI‑nak, a Meta Platforms‑nak, a Google‑nak, Snap‑nak, xAI‑nak és Character.ai‑nak, és információt kért arról, hogyan kezelik a gyerekekkel folytatott interakciókat, milyen biztonsági és szűrőmechanizmusok vannak beépítve, hogyan szabályozzák az AI‑chatbotok „barátként” való szerepét, valamint milyen módon tájékoztatják a szülőket a potenciális veszélyekről.

A kezdeményezés hátterében több olyan eset áll, ahol AI chatbot interakciók túlzott kockázattal jártak. Szülők olyan tragikus esetekre hívták fel a figyelmet, melyekben tinédzserek öngyilkossági szándékot fejeztek ki, és a chatbot válaszaiban nem találták meg azt a támogatást vagy segítő irányt, amit egy nehéz lelki helyzetben elvártak volna.

A cégek a vizsgálat kapcsán azt állítják, hogy már elkezdtek intézkedni és bevezettek szűrőket, korlátozásokat (például bizonyos témákat nem engednek felhozni fiatal felhasználóknál), és dolgoznak rajta, hogy jobban felismerjék, ha a felhasználó érzelmi distresszben van. Ugyanakkor az FTC azt szeretné tudni, hogy ezek a lépések mennyire hatékonyak, mennyire rendszeresek, és hogy ténylegesen védenek‑e a káros következményektől?

Ez a vizsgálat egy fontos mérföldkő abban, ahogy a technológiai és jogi szabályozás igyekszik lépést tartani az AI‑fejlődéssel, különösen a fiatalok védelme terén. Ha az AI chatbotokat „csak barátként” reklámozzák, könnyen előfordulhat, hogy a felhasználók túlzott bizalmat táplálnak irántuk, olyan szituációkban is, amikor valódi, szakszerű segítségre lenne szükség. Az FTC vizsgálata remélhetőleg rávilágít arra, hogy milyen gyakorlati intézkedések szükségesek, például korhatár‑ellenőrzés, érzékeny tartalom‑szűrés, krízisintervenciós protokollok, hogy ezek a chatbotok ténylegesen ne jelentsenek kockázatot a fiatal felhasználók számára.

Források: